Oorspronkelijk verschenen in het FD van zaterdag 13 mei. Essay door Jim Stolze.

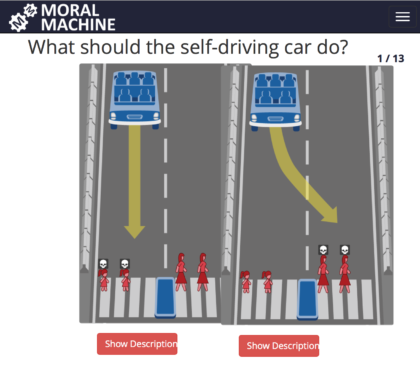

Het is woensdagmiddag. Kort na de lunch gaan Jip en Annelies (een tweeling van 8 jaar oud) de deur uit om de hond uit te laten. Een stuk verderop stuurt een zelfrijdende auto met een ouder echtpaar op de achterbank diezelfde straat in. De man (89 jaar oud) heeft kort geleden te horen gekregen dat hij ongeneeslijk ziek is en heeft een afspraak met zijn behandelend arts. Jip en Annelies zien het voetgangerslicht op groen springen en huppelen het zebrapad op. Op hetzelfde moment krijgt de zelfrijdende auto een melding dat het remsysteem is uitgevallen. In een fractie van een seconde overweegt het besturingssysteem twee opties:  1. Door rood rijden met de dood van de twee kinderen tot gevolg, of 2. Het stuur omgooien en de auto in volle vaart tegen een muur laten botsen, wat het einde aan het leven van de twee inzittenden zou betekenen.

1. Door rood rijden met de dood van de twee kinderen tot gevolg, of 2. Het stuur omgooien en de auto in volle vaart tegen een muur laten botsen, wat het einde aan het leven van de twee inzittenden zou betekenen.

Wat vindt u dat de auto zou moeten doen? De meeste deelnemers aan dit gedachte-experiment vinden dat het leven van de kinderen voorrang zou moeten krijgen. Minder uitgesproken zijn de ondervraagden wanneer we kleine onderdelen binnen het experiment aanpassen. Zou u dezelfde mening zijn toegedaan wanneer de kinderen de verkeersregels hadden overtreden door rood te lopen? Of wanneer het slechts één kind betrof en de auto vol zat met vijf kwieke senioren op weg naar hun wekelijkse yoga-klas? Met dit soort morele dilemma’s houden onderzoekers van het MIT Medialab zich bezig. Zij proberen inzicht te krijgen in menselijke besluitvorming om zo beter in te kunnen spelen op de vergaande digitalisering van de maatschappij.

Immers, we besteden steeds meer onderdelen van ons leven uit aan machines. Software is stilletjes uit onze computers geslopen en klimt via onze vingers en armen richting onze hersenen. Daarmee neemt software niet alleen over wat we doen, wat we denken, maar ook wát we ervan zouden moeten denken. Het gevaar dat op de loer licht is dat we zo ook de verantwoordelijkheid voor onze daden uitbesteden. Dat voelt als een brug te ver. Prima dat machines de arbeidsmarkt komen versterken, en gezellig dat we robots ook op straat tegen kunnen komen, maar wij –de mensen- kunnen de verantwoordelijkheid voor onze geautomatiseerde daden niet afschuiven op ons gereedschap ook al vertoont dat gereedschap menselijk trekjes.

Data graaien

Het debat over de ethiek van kunstmatige intelligentie wordt vooral gevoerd in het licht van data verzamelen en data verwerken. Zo waarschuwt belangenorganisatie Bits of Freedom al langer voor zogenaamde data-sleepnetten. Dat zijn doelbewuste acties van overheden en bedrijfsleven om zoveel mogelijk informatie te verzamelen in plaats van alleen wat relevant is voor de situatie. Verfrissend is dan bijvoorbeeld de benadering van De Correspondent. Zij hanteren een “data luw”-beleid: om de verhalen van hun journalisten te lezen hoef je slechts je naam en e-mailadres op te geven. Aanvullende gegevens zoals geslacht, geboortedatum en postcode zijn niet interessant omdat De Correspondent geen adverteerders heeft om deze data mee te delen.

Alle organisaties in de publieke en private sector zouden hierover beleid moeten formuleren, al was het alleen al omdat in mei 2018 de Wet bescherming persoonsgegevens vervangen wordt door de Algemene verordening gegevensbescherming (AVG). In de hele Europese Unie geldt dan een nieuwe privacy-wetgeving.

Techniek is niet neutraal: houd het stuur in handen. https://t.co/ixvTH7QSW6 #FD RDS FACT principes in de schijnwerpers @dsce @ReDaSci

— Wil van der Aalst (@wvdaalst) May 13, 2017

Verantwoord data snuffelen

Naast het verzamelen van de data zou ook het verwerken van de data niet vrij moeten zijn van ethische reflectie. Sinds 2016 werkt een collectief van Nederlandse universiteiten aan “Responsible Data Science”. De onderzoekers adviseren om bij het verwerken van data de volgende vier criteria van het FACT-principe in acht te nemen:

Fairness (zonder vooroordeel). Voorkom dat groepen die slecht vertegenwoordigd waren bij het verzamelen van de data nadeel ondervinden van de uiteindelijke werking. Zo zal Google er nog jaren aan worden herinnerd dat bij de eerste versies van hun foto-herkenningsoftware de selfies van mensen met een donkere huidkleur per ongeluk werden gecategoriseerd als gorilla’s.

Accuracy (zorgvuldig). Als je maar genoeg hypotheses onderzoekt, is er altijd wel eentje die per ongeluk waar lijkt te zijn. Hilarisch voorbeeld is te vinden in de Amerikaanse staat Maine waar het aantal echtscheidingen bijna perfect correleert met de verkoop van margarine. Dát er een verband lijkt te zijn wil nog niet zeggen dat je er een conclusie aan mag verbinden.

Confidentiality (vertrouwelijk). Hoe kun je garanderen dat privacygevoelige informatie wordt gerespecteerd? Als in 2018 de AVG van toepassing wordt, kunnen sommige bedrijven verplicht worden een privacy impact assessment uit te voeren of zelfs een functionaris voor de gegevensbescherming aan te stellen.

Transparancy (transparantie). Is de manier waarop je tot een uitkomst komt verdedigbaar en inzichtelijk? Als mensen zich benadeeld voelen door jouw algoritme, kunnen ze inzicht eisen in hoe het algoritme werkt.

Deze vier criteria vormen een goed fundament voor een nieuwe privacy statement, of het inrichten van een “privacy board”. Iets dat bij ING al is gebeurd. De bank heeft geleerd van de commotie die enkele jaren gelden ontstond bij een proefballonnetje rond big data en heeft een stuurgroep in het leven geroepen die één keer per maand bij elkaar komt om nieuwe projectvoorstellen te beoordelen op ethische aspecten en ook het mandaat heeft om voorstellen af te wijzen.

Maar met het in acht nemen van de privacyregels en het opzetten van een verantwoord data verwerkingsbeleid hebben we het probleem van de morele dilemma’s nog niet opgelost. Techo-optimisten geloven dat “het goede doen” in de toekomst meegeprogrammeerd kan worden in de software. Ze noemen dat ethical by design. Hoe zeer ik mezelf ook onder de techno-optimisten schaar, denk ik dat die toekomst nog erg ver weg is. Van de honderden onderzoekers naar kunstmatige intelligentie in Nederland is er slechts een handvol bezig met de grote vragen rondom ethiek.

Data-science wordt wel eens vergeleken met een raket. Data is in die vergelijking de brandstof en kunstmatige intelligentie vormt de motor. Alle bijbehorende processen kun je op een veilige manier –al dan niet met FACT- inrichten. Maar waar de raket naartoe moet vliegen, dát is de echte vraag. De richting bepalen vereist een morele afweging.

De grote vragen van dit moment verdienen een antwoord, een juiste richting. Net als dat bedrijven ethische commissies instellen, pleit ik voor een nationale raad van wetenschappers. En niet alleen vertegenwoordigers van de afdelingen informatica en datascience, maar juist ook filosofen, juristen en ethici.

We kunnen deze discussies niet voor ons uit blijven schuiven. Hoe meer we de tekortkoming van machines leren kennen, hoe beter we onszelf leren kennen. Het is een misverstand dat technologie neutraal zou zijn. Dat is niet zo. Technologie is slechts een hefboom op onze eigen intenties. Laten wij daarom in godsnaam nog even aan het stuur blijven zitten en eerst de best mogelijke richting van onze toekomst bepalen.